Même si certains diront « tout maîtriser », il faut savoir reconnaître que nous sommes manipulé-e-s la plupart du temps par un fonctionnement très spécial de notre cerveau. L’immense majorité des milliers de décisions que nous prenons au quotidien le sont en mode « pilotage automatique », sous l’impulsion forte, mais incontrôlée, de nombreux biais cognitifs. Un biais cognitif est une distorsion dans le traitement cognitif d’une information. On imagine alors que comprendre ces biais cognitifs est un réel enjeu stratégique, tant pour les déjouer que pour les utiliser dans nos actions.

Les biais cognitifs constituent un sujet qui me passionne depuis de nombreuses années. Dans le domaine de la cybersécurité, on imagine aisément que comprendre ces biais, et être capables de les utiliser, nous donnerait un avantage stratégique très important : déjouer les attaques, et manipuler l’attaquant !

L’objectif n’est pas ici de faire une liste sans fin de tous les biais qui existent, mais plutôt de présenter comment, au quotidien, ils peuvent altérer les plus aguerris d’entre nous. Les analystes, les experts forensics, les spécialistes du renseignement, les meilleurs pilotes de cellules de crises… tous sont susceptibles à un moment ou à un autre de laisser un biais prendre le contrôle de leurs réflexions, de leurs décisions.Tout le monde est concerné par les déviances que les biais cognitifs peuvent engendrer.

On ne sera jamais certain d’éviter d’être la victime d’un biais. Mais on doit essayer de tout faire pour éviter qu’il ne nous piège au mauvais moment. D’ailleurs, il est quasi certain que j’ai dû en être victime moi aussi en rédigeant cette série d’articles. L’influence de mon travail, de mes collègues, de mes mentors… Tout le monde est concerné par les déviances que les biais cognitifs peuvent engendrer. Un des pièges à éviter, c’est de ne pas céder au biais de l’angle mort, et croire que les biais cognitifs sont davantage présents chez les autres que chez soi.

Des menaces dont il est difficile d’appréhender la réalité

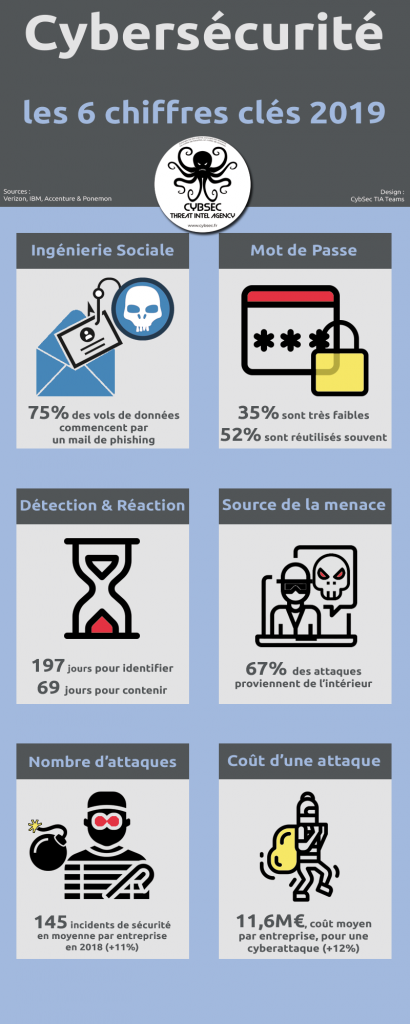

En cybersécurité, la perception du risque est particulière du fait d’un manque d’information à jour sur les menaces. Ces dernières étant très évolutives et mouvantes, nous n’avons général qu’une vue très partielle du son contexte complet du risque.

Nous savons que la menace est réelle, mais il est très compliqué de quantifier le risque qui y est associé. Pire encore, certains ne se sentent pas toujours concernés (effet Dunning Kruger : la plupart des gens pensent qu’ils ne seront pas victimes d’incidents de sécurité), même si cela tend à changer.Nous sommes désormais de plus en plus conscients qu’être attaqués sera une réalité, mais nous n’arrivons toujours pas à pleinement anticiper cette réalité, et à en évaluer le risque.

En effet, nous sommes désormais de plus en plus conscients qu’être attaqués sera une réalité, mais nous n’arrivons toujours pas à pleinement anticiper cette réalité, et à en évaluer le risque.

Nous pouvons aujourd’hui qualifier leurs coûts tangibles : vol de fonds (directs ou via une rançon), dommages causés aux systèmes, amendes pour infractions aux règlements, compensations financières. Et nous savons à peu près définir leurs coûts non palpables qui pourraient inclure la perte d’un avantage concurrentiel liée au vol de propriété intellectuelle, la perte de confiance, l’atteinte à la réputation, la décrédibilisation de la marque, etc.

Mais au-delà de ces dommages que nous savons potentiellement mesurer, les cyberattaques prennent désormais une ampleur capable de causer des pannes d’infrastructure à une échelle beaucoup plus grande, capable d’affecter des interconnexions complexes entre plusieurs industries, entre plusieurs business, et potentiellement déstabiliser des systèmes financiers ou industriels complets.

L’objectif ici n’est pas de décrire les risques, et d’apporter une réponse à leurs qualifications, mais d’avancer sur une des nombreuses questions que l’on pourrait se poser pendant une cyberattaque : comment prendre les bonnes décisions dans un contexte de crise cyber ?

Là encore, je ne vais pas m’aventurer à débattre sur la définition d’une cellule de crise, ou le « comment bien gérer une crise cyber », car ce n’est pas mon métier premier, mais je vais plutôt m’intéresser à l’humain au milieu de cette crise. L’Humain et, avec lui, les organisations qu’il a construites, sont des édifices fragiles et faillibles. Et évidemment, les biais cognitifs sont souvent au cœur de cette fragilité.

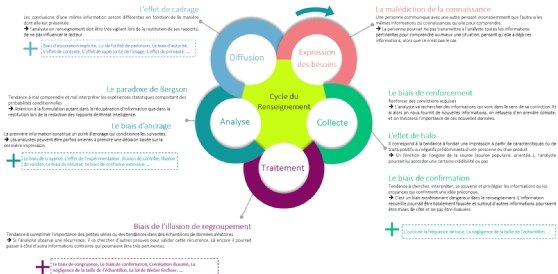

Je vais essayer de centrer cette série d’articles sur 4 domaines pour lesquels les biais cognitifs auront une action déterminante sur la prise de décision des équipes en charge de gérer les risques, une crise, du renseignement ou la riposte contre l’adversaire.

https://www.lemagit.fr/tribune/Cybersecurite-les-biais-cognitifs-dans-tous-leurs-etats-1-5